Linux

- Allgemein

- Datenspeicher

- Alte Festplatte mit Linux auslesen MS-DOS

- Festplatte Klonen

- Festplatte überprüfen

- Festplatte vergrößern

- Festplatten in Linux

- Festplatten unter Linux prüfen

- Linux Festplatte untersuchen

- Docker

- Fedora

- Firewall

- Verschlüsseln und Datenschutz

- GnuPG

- GPG-Signaturen überprüfen

- Ordner verschlüsseln

- Tor Systemweit

- Verschlüsseln von Dateien und E-Mails

- VPN über Tor

- Ändern des Displaymanagers

- Automatische Updates für Linux Server

- Autostart in Linux

- Bash Aliases

- Bash Scripting

- Benutzer und Gruppen in Linux

- Bitlocker to Go

- Chat-GPT in der Konsole

- Datenrettung

- deb installieren

- Desktop Verknüpfung Linux

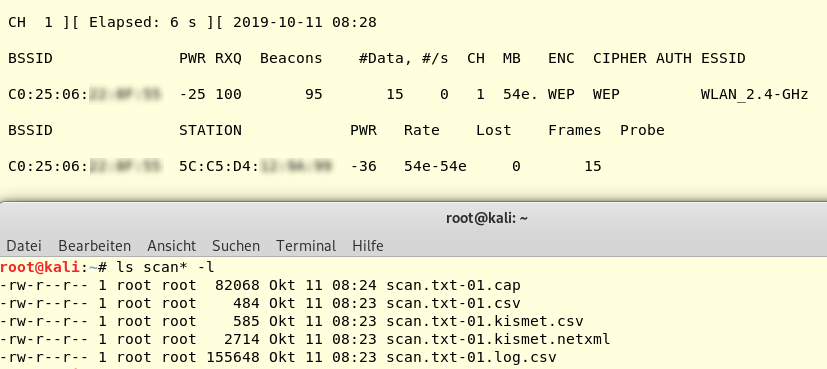

- Ethical Hacking mit Python und Kali Linux

- Flatpak installieren

- Flatpak rechte Erweiterung

- FTP Im Terminal verwenden

- FTP Server installieren für Paperless

- Gnome Desktop anpassen

- Grub Bootloader erweitern

- Hacking Akademie

- John the Ripper installieren

- Kali John the ripper

- linkedin Learning Linux Systemarchitektur

- Linux auf Deutsch umstellen

- Linux geheimnisse

- Linux härten

- Linux LPIC Prüfung

- Linux Tipps Readly

- Nginx Reverse Proxy

- NixOS

- OpenVPN

- Pacman

- Qemu Agent installieren

- Raspberry Matrix

- Rebalance-LND

- Server Sicherheit erhöhen

- SSH

- Terminal Befehle

- Tipps zu Linux

- Treiber & Hardware für Linux

- Ubuntu Server Netzwerk

- UFW Firewall

- Unifi-Server

- Update Ubuntu Distribution

- Vertrauenswürdige SSL Zertifikate im Internen Netz

- Wireguard VPN erstellen

- Hardwareinfo

- Webdav in Linux

Allgemein

XRDP installieren

Xrdp installieren

The only package you need is xrdp, which you should enable after installation.

sudo apt update

sudo apt install xrdp

sudo systemctl enable xrdp

sudo systemctl restart xrdp

Zeitzone ändern

verfügbare Zeitzonen auflisten

timedatectl list-timezonesZeitzone Setzen

sudo timedatectl set-timezone Europe/CopenhagenZeitzone überprüfen

timedatectl

Datenspeicher

Alte Festplatte mit Linux auslesen MS-DOS

1. Überprüfen, ob die Festplatte erkannt wird

Zunächst musst du sicherstellen, dass die Festplatte vom Linux-System erkannt wird. Du kannst dies mit den folgenden Befehlen überprüfen:

-

lsblk: Listet alle Blockgeräte auf, einschließlich Festplatten und Partitionen

sudo lsblk

fdisk -l: Zeigt detaillierte Informationen zu allen erkannten Festplatten und deren Partitionen an.

sudo fdisk -l

dmesg: Zeigt Systemprotokolle und Meldungen an, auch wenn ein Gerät (wie die Festplatte) angeschlossen wird. Dies kann hilfreich sein, um Fehler oder fehlende Treiber zu erkennen.

dmesg | grep -i usb

Wenn du die Festplatte nicht siehst, kann es an einem Problem mit der Verbindung (Adapter, Kabel, etc.) oder an einem Fehler mit der Festplatte selbst liegen. Achte darauf, dass der USB-zu-IDE-Adapter korrekt funktioniert und dass die Festplatte ordnungsgemäß angeschlossen ist.

2. Überprüfen der Partitionen auf der Festplatte

MS-DOS verwendet häufig ein FAT16-Dateisystem oder ältere Versionen von FAT32. Wenn Linux die Festplatte erkennt, aber keine Partitionen anzeigt, könnte es an einem Problem mit der Partitionstabelle liegen. Versuche, mit den folgenden Tools die Partitionen zu identifizieren.

-

fdisk: Auch wennlsblkkeine Partitionen anzeigt, kannst du mitfdiskauf der Festplatte nach Partitionen suchen.

sudo fdisk /dev/sdX

-

Ersetze

/dev/sdXdurch die entsprechende Festplatte (z.B./dev/sdb). Du kannst dann imfdisk-Menü mitpdie Partitionstabelle anzeigen lassen und nachsehen, ob Partitionen vorhanden sind. -

partprobe: Falls eine Partitionstabelle vorhanden ist, aber nicht erkannt wird, kannst dupartprobeverwenden, um die Partitionstabelle erneut zu lesen

sudo partprobe

3. Mounten der Partitionen

Wenn du die Partitionen siehst, kannst du sie mit mount einhängen (mounten). Angenommen, deine Partition ist /dev/sdb1:

-

Erstelle ein Verzeichnis, in das du die Partition mounten möchtest:

sudo mkdir /mnt/dos

Mounten der Partition:

sudo mount /dev/sdb1 /mnt/dos

Jetzt kannst du auf die Daten auf der Partition zugreifen, indem du in das Verzeichnis /mnt/dos navigierst:

cd /mnt/dos

ls

4. Fehlerbehebung bei Dateisystemen

Falls du beim Mounten auf ein Problem stößt (z.B. das Dateisystem wird nicht erkannt), könnte es daran liegen, dass die Festplatte mit einem älteren oder unbekannten Dateisystem formatiert wurde. MS-DOS verwendet in der Regel FAT16 oder FAT32.

-

Wenn die Partition mit FAT16 oder FAT32 formatiert wurde, sollte Linux diese ohne Probleme erkennen können. Falls das Dateisystem jedoch beschädigt ist, kannst du versuchen, es mit

fsckzu reparieren:

sudo fsck.vfat /dev/sdb1

Dies ist der Befehl für die Reparatur von FAT-Dateisystemen. Falls du ein anderes Dateisystem (z.B. NTFS oder EXT) hast, musst du das passende fsck-Tool verwenden.

5. Falls die Festplatte nicht erkannt wird:

-

Überprüfen mit

dmesg: Wenn du keine Festplatte siehst, die mitlsblkoderfdiskerkannt wird, dann verwendedmesg, um zu sehen, ob es beim Anschluss der Festplatte zu Fehlern kommt:

dmesg | tail -n 20

-

Dies zeigt die letzten 20 Zeilen der Systemmeldungen. Wenn Fehler bei der Erkennung oder beim Mounten angezeigt werden, könnte dies auf ein Problem mit der Festplatte oder dem USB-zu-IDE-Adapter hinweisen.

-

Festplatte könnte beschädigt sein: Falls du immer noch keine Partition oder Festplatte sehen kannst, könnte sie beschädigt sein. In diesem Fall kannst du versuchen, mit Tools wie

testdiskzu prüfen, ob du verloren geglaubte Partitionen wiederherstellen kannst.Installiere

testdisk:

sudo apt-get install testdisk

Starte testdisk:

sudo testdisk

-

Folge den Anweisungen, um nach Partitionen zu suchen und sie gegebenenfalls wiederherzustellen.

Zusammenfassung der Schritte:

- Überprüfen, ob die Festplatte erkannt wird (mit

lsblk,fdisk,dmesg). - Partitionen anzeigen lassen (mit

fdiskoderpartprobe). - Partitionen mounten (mit

mount). - Bei Problemen mit dem Dateisystem, Reparaturversuche mit

fsck. - Verwenden von

testdisk, um verlorene Partitionen wiederherzustellen, falls nötig.

Falls weiterhin Probleme auftreten, könnte es an der Festplatte, dem Adapter oder einer fehlerhaften Partitionstabelle liegen.

Festplatte Klonen

Klonen von Festplatten oder USB-Sticks kann so einfach sein.

Herausfinden, unter welcher Bezeichnung die Festplatte/USB-Stick eingebunden sind:

lsblkDetaillierte ansicht aller Festplatten

sudo lshw -class disk -short

Image eines Speichermediums erstellen

sudo dd if=/dev/sda of=/mnt/daten/backup.imb bs=4M status=progressPartitionen klonen

Achtung!

Es sollte darauf geachtet werden, dass die Ziel-Partition gleich groß oder größer als die Quelle-Partition ist.

Der folgende Befehl klont (kopiert) die komplette Partition /dev/sda1 auf die Partition /dev/sdb1:

dd if=/dev/sda1 of=/dev/sdb1

Weitere Optionen:

| conv=noerror | Diese Option weist dd an, beim Auftreten eines Lese oder Schreibfehlers nicht abzubrechen. |

| sync |

diese OPtion sorgt dafür, dass dd beim Auftreten eines Fehlers "leere" Blöcke anstelle der fehlerhaften Blöcke in die Ausgabedatei schreibt |

sudo dd if=/dev/sda of=/dev/sdb conv=noerror,sync bs=4M status=progress

Man soll sich im Klaren sein, dass dabei alle Partitionsattribute dupliziert werden (Größe, UUID, Label). Alle Geräte mit den dazugehörigen Informationen kann man auflisten:

sudo blkid

Wenn die Ziel-Partition größer als die Quelle ist, kann man das Zielfilesystem auf die gesamte Partition ausdehnen:

sudo resize2fs /dev/sdb1

Festplatte aus Image wiederherstellen

sudo dd if=/tmp/sda.img of=/dev/sda bs=4M status=progressFestplatte überprüfen

Um die Gesundheit einer NVMe-Festplatte unter Linux zu überprüfen, verwendest du am besten das Terminal-Tool smartctl aus dem Paket „smartmontools“. Seit smartctl Version 6.5 werden auch NVMe-SSDs unterstützt[6][1].

Schritte:

-

Paket installieren:

bash sudo apt update sudo apt install smartmontools(Abhängig von deiner Distribution kann der Befehl abweichen)[3][2]. -

NVMe-Gerät identifizieren:

Liste alle Datenträger auf, meist heißt das NVMe-Laufwerk/dev/nvme0n1:bash lsblk | grep -v ^loopSuche in der Ausgabe nach deinem NVMe-Laufwerk[3]. -

SMART-Informationen abrufen:

Für eine schnelle Übersicht des Gesundheitszustandes:bash sudo smartctl -a /dev/nvme0n1(Passe den Gerätenamen ggf. an)[1][3][6].Für einen Kurztest:

bash sudo smartctl -H /dev/nvme0n1BeiPASSEDist der aktuelle Status unauffällig. ErscheintFAILED, ist die SSD kritisch gefährdet[1].Für detaillierte Informationen, wie Temperatur, gelesene/geschriebene Daten, Medienfehler oder zusätzliche Warnungen:

bash sudo smartctl --all /dev/nvme0n1Diese Werte geben dir Hinweise auf Alterung oder drohende Probleme[3].

Hinweis:

- Die Werte findest du in der Tabelle in der smartctl-Ausgabe. Sie enthalten u.a. „Percentage Used“, „Data Units Written“, „Media and Data Integrity Errors“ usw. - Für detaillierte Auswertung lies die einzelnen Attribute und ihren Status[1][3][6].

Alternative:

- Zusätzlich zur smartctl-Methode gibt es für NVMe-Laufwerke auch das Tool nvme-cli, das ebenfalls Diagnosedaten auslesen kann[8].

Beispiel: bash

sudo nvme smart-log /dev/nvme0n1

Dieses gibt die wichtigsten Gesundheits-Indikatoren speziell für NVMe zurück.

Fazit:

Der Standardweg ist die Nutzung von smartctl und/oder nvme-cli mit dem richtigen Gerätenamen. Die wichtigsten Ergebnisse sind der „Overall-health self-assessment“-Test („PASSED“/„FAILED“) und die Detailwerte aus der umfangreichen Ausgabe[1][3][6][8].

Festplatte vergrößern

How to resize/extend a btrfs formatted root partition

Environment

SUSE Linux Enterprise Server 12 (all Service Packs)

Situation

- Is the original disk going to be expanded?

- Is it possible to add a new disk to expand the existing btrfs file system?

The following article will cover a situation with one disk and two partitions to show the steps necessary for both scenarios using both offline as well as online resize operation.

Please keep in mind that a more sophisticated partitioning scheme (partitions behind the root volume or an extended partition layout) may cause problems. In these cases adding a new disk to expand the existing file system is the preferred solution.

Please check the system setup carefully before carrying out any actions.

Because the procedures covered in this article contain a fair risk of losing the operating system while performing changes to the partition table, the administrator of the machine is required to create a backup before the operation!

This guide does not claim to be complete or cover all possible scenarios. In case of questions please open a service request to discuss these with SUSE Technical Services before any action is taken.

Resolution

The disk space of a virtual system with 20GB hard disk should be increased to 40GB.

Preparation:

- Since the following procedure requires changes to the partition table, a loss of data is possible. Please ensure to create a backup of the system before performing any action!

- Ensure your restore procedure works correctly!

- Check carefully if a MSDOS or GPT partition table was created. This information can easily be obtained from the parted -l / fdisk -l output easily.

This article is going to cover the following three approaches to accomplish the resize of a virtual disk in a VMware based environment:

- Expanding the file system by adding a new disk

- Resizing the disk using parted

- Resizing the disk online using fdisk

Expanding the file system by adding a new disk

A convenient and quick solution to add disk space to an existing btrfs file system is by adding a new disk.

The procedure consists of four steps and the system does not need to be rebooted:

- add a new disk

- rescan the SCSI bus using

rescan-scsi-bus.sh -a

- Add the newly added device to the root btrfs filesystem

btrfs device add /dev/sdX /

- At this point the metadata is only stored on the first disk, to distribute (balance) it across the devices run:

btrfs filesystem balance /

server1:~ # parted -l Model: VMware Virtual disk (scsi) Disk /dev/sda: 21.5GB Sector size (logical/physical): 512B/512B Partition Table: msdos Disk Flags: Number Start End Size Type File system Flags 1 1049kB 4302MB 4301MB primary linux-swap(v1) type=82 2 4302MB 21.5GB 17.2GB primary btrfs boot, type=83

As a first step, the virtual disk needs to be increased on the hypervisor side. Please refer to the vendor documentation for this particular task. The parted -l output above also provides the information whether a MSDOS or GPT partition label was used. fdisk -l (an example is provided in the section Resizing the partition online using fdisk ) will show this information.

Once this has been accomplished, rescan the local disk:

server1:~ # echo 1 > /sys/block/sda/device/rescan server1:~ # parted -l Model: VMware Virtual disk (scsi) Disk /dev/sda: 42.9GB Sector size (logical/physical): 512B/512B Partition Table: msdos Disk Flags: Number Start End Size Type File system Flags 1 1049kB 4302MB 4301MB primary linux-swap(v1) type=82 2 4302MB 21.5GB 17.2GB primary btrfs boot, type=83

Trying to resize /dev/sda using parted will fail with:

server1:~ # parted /dev/sda GNU Parted 3.1 Using /dev/sda Welcome to GNU Parted! Type 'help' to view a list of commands. (parted) resize Partition number? 2 Error: Partition /dev/sda2 is being used. You must unmount it before you modify it with Parted. (parted)

Warning The file system is currently mounted on /. You can try to unmount it now, continue without unmounting or cancel. Click Cancel unless you know exactly what you are doing.

Once the rescue system has started, the disk resize operation may be performed as follows:

0:rescue:~ # parted /dev/sda GNU Parted 3.1 Using /dev/sda Welcome to GNU Parted! Type 'help' to view a list of commands. (parted) resize Partition number? 2 End? [21.5GB]? 42.5GB (parted) quit Information: You may need to update /etc/fstab.

Running parted -l will show the new end of the partition:

0:rescue:~ # parted -l

Model: VMware Virtual disk (scsi)

Disk /dev/sda: 42.9GB

Sector size (logical/physical): 512B/512B

Partition Table: msdos

Disk Flags:

Number Start End Size Type File system Flags

1 1049kB 4302MB 4301MB primary linux-swap(v1) type=82

2 4302MB 42.5GB 38.2GB primary btrfs boot, type=83

0:rescue:~ # mount /dev/sda2 /mnt 0:rescue:~ # btrfs filesystem resize max /mnt Resize '/mnt' of 'max' 0:rescue:~ # df -h Filesystem Size Used Avail Use% Mounted on /dev/loop0 29M 29M 0 100% /parts/mp_0000 /dev/loop1 14M 14M 0 100% /parts/mp_0001 devtmpfs 468M 0 468M 0% /dev /dev/loop2 42M 42M 0 100% /mounts/mp_0000 /dev/loop3 34M 34M 0 100% /mounts/mp_0001 /dev/loop4 4.2M 4.2M 0 100% /mounts/mp_0002 tmpfs 497M 0 497M 0% /dev/shm tmpfs 497M 7.2M 490M 2% /run tmpfs 497M 0 497M 0% /sys/fs/cgroup tmpfs 497M 0 497M 0% /tmp tmpfs 100M 0 100M 0% /run/user/0 /dev/sda2 36G 753M 33G 3% /mnt

Resizing the partition online using fdisk

fdisk does not support resizing a partition. In this case the existing root partition needs to be deleted and recreated using the same start block but selecting the new end block to assign all available disk space to the partition.

As already mentioned before, fdisk cannot deal with GPT partition tables. Please check carefully which label was chosen and select the right tool for the resize operation.

When recreating the partition please make sure to set the bootable flag again, otherwise the system will not boot.

The procedure using fdisk is as follows:

Print the current partition table, save it, expand the disk, have the kernel rescan the device and make sure it sees the new size:

server1:~ # fdisk -l Disk /dev/sda: 20 GiB, 21474836480 bytes, 41943040 sectors Units: sectors of 1 * 512 = 512 bytes Sector size (logical/physical): 512 bytes / 512 bytes I/O size (minimum/optimal): 512 bytes / 512 bytes Disklabel type: dos Disk identifier: 0x0004a8ed Device Boot Start End Sectors Size Id Type /dev/sda1 2048 8402943 8400896 4G 82 Linux swap / Solaris /dev/sda2 * 8402944 41943039 33540096 16G 83 Linux btrfs:~ # echo 1 > /sys/block/sda/device/rescan btrfs:~ # fdisk -l Disk /dev/sda: 40 GiB, 42949672960 bytes, 83886080 sectors Units: sectors of 1 * 512 = 512 bytes Sector size (logical/physical): 512 bytes / 512 bytes I/O size (minimum/optimal): 512 bytes / 512 bytes Disklabel type: dos Disk identifier: 0x0004a8ed Device Boot Start End Sectors Size Id Type /dev/sda1 2048 8402943 8400896 4G 82 Linux swap / Solaris /dev/sda2 * 8402944 41943039 33540096 16G 83 Linux server1:~ #

Keep in mind, operations in fdisk are temporary until a write operation is issued. So at any point it is safe to exit fdisk using CTRL+c.

As a next step open fdisk and delete the root partition.

server1:~ # fdisk /dev/sda Welcome to fdisk (util-linux 2.28). Changes will remain in memory only, until you decide to write them. Be careful before using the write command. Command (m for help): d Partition number (1,2, default 2): 2 Partition 2 has been deleted.

Command (m for help): n

Partition type

p primary (1 primary, 0 extended, 3 free)

e extended (container for logical partitions)

Select (default p): p

Partition number (2-4, default 2):

First sector (8402944-83886079, default 8402944):

Last sector, +sectors or +size{K,M,G,T,P} (8402944-83886079, default 83886079):

Created a new partition 2 of type 'Linux' and of size 36 GiB.

Command (m for help): t

Partition number (1,2, default 2): 2

Partition type (type L to list all types): 83

Changed type of partition 'Linux' to 'Linux'.

Command (m for help): a Partition number (1,2, default 2): 2 The bootable flag on partition 2 is enabled now.

Command (m for help): p Disk /dev/sda: 40 GiB, 42949672960 bytes, 83886080 sectors Units: sectors of 1 * 512 = 512 bytes Sector size (logical/physical): 512 bytes / 512 bytes I/O size (minimum/optimal): 512 bytes / 512 bytes Disklabel type: dos Disk identifier: 0x0004a8ed Device Boot Start End Sectors Size Id Type /dev/sda1 2048 8402943 8400896 4G 82 Linux swap / Solaris /dev/sda2 * 8402944 83886079 75483136 36G 83 Linux

Now, while writing the changes to disk, the following messages will be shown:

Command (m for help): w The partition table has been altered. Calling ioctl() to re-read partition table. Re-reading the partition table failed.: Device or resource busy The kernel still uses the old table. The new table will be used at the next reboot or after you run partprobe(8) or kpartx(8). server1:~ # partprobe Error: Partition(s) 2 on /dev/sda have been written, but we have been unable to inform the kernel of the change, probably because it/they are in use. As a result, the old partition(s) will remain in use. You should reboot now before making further changes. Error: Can't have a partition outside the disk!

Once the system is back online please run:

btrfs filesystem resize max /

SLE 12 based systems support the ioctls mentioned previously, this way it is possible to notify the kernel about the changed partition table as the system is online.

Old partition table:

server1:~ # fdisk -l /dev/sda Disk /dev/sda: 20 GiB, 21474836480 bytes, 41943040 sectors Units: sectors of 1 * 512 = 512 bytes Sector size (logical/physical): 512 bytes / 512 bytes I/O size (minimum/optimal): 512 bytes / 512 bytes Disklabel type: dos Disk identifier: 0x000dd878 Device Boot Start End Sectors Size Id Type /dev/sda1 2048 8402943 8400896 4G 82 Linux swap / Solaris /dev/sda2 * 8402944 41943039 33540096 16G 83 Linux

Execute the actions as displayed above to remove and recreate the partition table, write the changes and receive the busy message from the kernel:

server1:~ # fdisk -l Disk /dev/sda: 50 GiB, 53687091200 bytes, 104857600 sectors Units: sectors of 1 * 512 = 512 bytes Sector size (logical/physical): 512 bytes / 512 bytes I/O size (minimum/optimal): 512 bytes / 512 bytes Disklabel type: dos Disk identifier: 0x000dd878 Device Boot Start End Sectors Size Id Type /dev/sda1 2048 8402943 8400896 4G 82 Linux swap / Solaris /dev/sda2 * 8402944 104857599 96454656 46G 83 Linux

server1:~ # cat /proc/partitions major minor #blocks name 2 0 4 fd0 8 0 52428800 sda 8 1 4200448 sda1 8 2 16770048 sda2 11 0 1048575 sr0

partx -u -n 2 /dev/sda

server1:~ # cat /proc/partitions major minor #blocks name 2 0 4 fd0 8 0 52428800 sda 8 1 4200448 sda1 8 2 48227328 sda2 11 0 1048575 sr0

Now resize the filesystem. (If the btrfs file system resides on multiple devices, see the Additional Information section of this document, as well.)

btrfs filesystem resize max /

btrfs filesystem usage /

Using partx it would also be possible to delete any partitions that are not needed behind the root volume, expand the root volume, delete the kernel view on that partition (partx -d -n X /dev/sda), update the root partition (partx -u -n X /dev/sda) and then resize the filesystem.

Additional Information

Another possible method to extend the disk space of a btrfs file system would be to add unused partitions from a disk. Please note that btrfs will treat these partitions (even if they come from the same device) as a separate physical volume and if later the file system should operate in RAID mode, chunks will be served from both partitions which is not desirable. In this case it is preferable to either add complete disks or delete unused partitions and resize the root volume where applicable.

If the btrfs file system resides on multiple devices

When a btrfs file system resides on mulitple devices, first determine the devid of resized partition, for example:

btrfs filesystem show /

btrfs filesystem resize 2:max /

Festplatten in Linux

Linux: Festplatten und Partitionen im Terminal anzeigen

Festplatten unter Linux prüfen

Wichtige Befehle

| Befehl | Auswirkung |

lsblk |

Übersichtliche Baumstrucktur aller Festplatten und Partitionen |

df -h |

Freien Speicherplatz anzeigen lassen |

sudo lvextend -l 100%VG ubuntu-vg/ubuntu-lv |

Weist den Speicherplatz der Partition zu Wenn sda3 30G - ubuntu--vg-ubuntu-vl 15G Danch sind die vollen 30G Ubuntu zugewiesen und weiter |

Formatieren

herausfinden welche Festplatte

Um in ext4 zu formatieren

mkfs.ext4 /dev/sdb1Partitionieren

- öffnet ein Terminal, indem ihr gleichzeitig die Tasten **Strg + Alt + T **drückt.

- Der Befehl

lsblkzeigt euch in einer Baumstruktur übersichtlich an, welche Partition zu welcher Festplatte gehört und wie groß sie sind. - Die erste Festplatte lautet sda. Ihre Partitionen lauten sda1, sda2, sda3 etc.

- Die zweite Festplatte lautet sdb. Ihre Partitionen lauten sdb1, sdb2, sdb3 etc.

- Der Befehl

blkid -o listzeigt euch zusätzlich noch die UUID, den Dateisystemtyp und die Bezeichnung der Partition an (sofern vergeben).

![Diese beiden Befehle geben euch eine Übersicht über eure Partitionen und Festplatten][2]

Diese beiden Befehle geben euch eine Übersicht über eure Partitionen und Festplatten

In unserem Beispiel hat unsere erste Festplatte sda folgende Partitionen:

- sda1: Von Windows angelegte Efi-Boot-System-Partition.

- sda2: Von Windows angelegte System-Reservierte-Partition.

- sda3: Partition, auf der Windows installiert ist (Bezeichnung: Windows).

- sda4: Partition, auf der Linux Mint installiert ist.

- sda5: SWAP-Partition für Linux Mint

Die zweite Festplatte sdb hat nur eine Partition:

- sdb1: Partition für Eigene Dateien, Programme und Spiele (Bezeichnung: Daten).

Alternative

Alternative gebt ihr im Terminal sudo fdisk -l ein und bestätigt mit eurem Passwort. Nun seht ihr eine ähnliche hilfreiche Ansicht:

![Auch der Befehl zeigt eine strukturierte Übersicht an.][2]

Auch der Befehl zeigt eine strukturierte Übersicht an.

Beachtet, dass in der Spalte Typ nicht der Dateisystem-Typ gemeint ist, sondern eine manchmal recht ungenaue Bezeichnung.

Hier findet ihr übrigens unsere Top-Software 2018 für Linux Mint:

Einbinden zusätzlicher Festplatten unter Linux

In diesem Tutorial möchten wir Ihnen zeigen, wie zusätzliche Festplatten unter Linux eingebunden und benutzt werden können.

Sollten Sie sich nicht sicher sein, ob Ihr Benutzer über die notwendigen Rechte verfügt, können Sie zu Beginn einer jeden SSH-Session das folgende Kommando ausführen:

sudo -i

Nach Ausführung des Kommandos erhalten Sie weiterführende (Root-) Berechtigungen ohne das Kommando „sudo“ jedem Befehl auf der Kommandozeile voranstellen zu müssen.

Zunächst einmal verschaffen wir uns einen Überblick über alle Disks, welche vom System erkannt werden. Dies machen wir mit folgendem Befehl:

fdisk -l

In unserem Beispiel sind zwei Festplatten verbaut: /dev/sda, die Festplatte, auf der das System installiert ist, sowie /dev/sdb, eine zusätzliche 50 GiB-Festplatte, welche wir in unser Betriebssystem einbinden möchten. Die Festplattenbezeichnung kann variieren, je nachdem, wie viele Festplatten in Ihrem Server eingebaut sind.

Zunächst einmal müssen wir eine Partition erstellen sowie gegebenenfalls eine Partitionstabelle schreiben. Selbstverständlich können auch mehrere Partitionen erstellt und eingebunden werden, in diesem Beispiel möchten wir jedoch die ganze Kapazität der Festplatte für eine Partition nutzen.

Hierzu verwenden wir cfdisk, die grafische Version von fdisk.

cfdisk /dev/sdb

Sollte auf der Festplatte noch keine Partitionstabelle vorhanden sein, öffnet sich nun ein Auswahlmenü:

Für unser Beispiel wählen wir dos. Hiermit wird eine MBR-Partitionstabelle auf die Festplatte geschrieben (für Festplatten, welche die Kapazität von 2 TB übersteigen, müssten wir GPT verwenden, um die gesamte Kapazität nutzen zu können).

Danach öffnet sich folgendes Fenster:

Nun können wir unsere Partition(en) erstellen. Wir erstellen eine 50 GiB-Partition, indem wir 50G eingeben und mit der Enter-Taste bestätigen.

Im nachfolgenden Dialog wählen wir primary, um eine Primäre Partition anzulegen.

Wir bestätigen das Ganze mit Write und tippen yes ein, um das Erstellen der Partition abzuschließen.

Um nun aber wirklich Daten auf die Festplatte schreiben zu können, müssen wir die angelegte Partition noch mit einem Filesystem ausstatten. Wir wählen also Quit, um die Oberfläche von cfdisk zu verlassen und vergewissern uns zunächst, ob die Partition ordnungsgemäß angelegt wurde. Dies machen wir abermals mit folgendem Befehl:

fdisk -l

Unsere erstellte Partition wird als /dev/sdb1 gelistet. Es ist also alles wie gewünscht verlaufen.

Wir formatieren die Partition nun mit einem Filesystem, in unserem Beispiel ext4. Wir tippen folgendes in unsere Konsole ein:

mkfs.ext4 /dev/sdb1

Die Formatierung der Partition ist hiermit abgeschlossen. Um jetzt Dateien auf der Festplatte speichern zu können müssen wir die Partition in unser System einbinden.

Dazu erstellen wir einen neuen Ordner, alle Dateien, die nach Abschluss der Prozedur in diesen Ordner erstellt oder verschoben werden, werden auf der neuen Festplatte gespeichert. In unserem Beispiel verwenden wir den Namen datastore für unseren Ordner, der Name ist jedoch frei wählbar. Mit folgendem Befehl erstellen wir den Ordner:

mkdir /datastore

Um die Partition nun in den erstellten Ordner einzubinden, benutzen wir folgenden Befehl:

mount /dev/sdb1 /datastore

Unsere erstellte Partition ist nun in /datastore eingebunden.

Damit die Partition auch nach einem Neustart des Servers wieder automatisch eingebunden wird, müssen wir noch die UUID unserer neuen Partition sowie eine Zeile in der /etc/fstab hinzufügen. Dazu führen wir zunächst folgenden Befehl aus:

blkid /dev/sdb1

Die UUID unserer Partition wird uns nun angezeigt. Diese kopieren wir uns ohne Anführungszeichen und öffnen die Datei /etc/fstab

nano /etc/fstab

Mit den Pfeiltasten navigieren wir den Cursor an das Ende der Datei und fügen folgende Zeile hinzu:

UUID=d6ae62ff-c9b7-4a07-aea8-a36f55c5036d /datastore ext4 defaults 0 0

Die UUID ist natürlich mit der eigenen, mittels blkid ausgelesenen UUID zu ersetzen.

Grafische Anzeige der Festplatten-Partitionen

- Öffnet das Startmenü und öffnet das Programm Systemüberwachung.

- Klickt oben auf den Reiter Dateisysteme.

Festplatten Analysieren

Unter Linux: Festplattenbelegung analysieren

wenn nicht installiert: sudo apt-get install baobab

Alternative im Terminal

Eine Alternative wenn kein Desktop installiert ist, ist ncdu

sudo apt install ncduPlatzfresser auflisten

Welche Dateien und Ordner belegen den meisten Plattenplatz? Auf SSDs und auf Platinenrechnern mit SD-Karten ist diese Frage wieder aktueller denn je. Für die Antwort gibt es im Bash-Terminal zahlreiche Lösungen, unter anderem mit „find -size“ oder mit dem interaktiven Tool ncdu. Für wirklich frappierend schnelle Informationen sorgen die hier beschriebenen Kommandos.

du -S | sort -n -r | head -n 20Schalter "-S" separiert die Ornder, damit nicht übergordnete Verzeichnisse automatisch zu Platzfressern werden, sondern tatsächlich die dafür verantwortlichen Unterodner. Nach der numerischen und absteigenden Sortierung(sort) liefert head schließlich die größten Ordner. Die Zahl - hier 20 - lässt sich beliebig definieren. Für das Auffinden der größten Einzeldateien ist das Tool tree, das eventuell mit gleichnamigem Paketnamen nachinstalliert werden muss, das Werkzeug der Wahl. Das geeignete Kommando

tree -isf | sort -n -r -k2 | head -n 20ähnelt dem du-Befehl, nur dass hier die Dateigröße nach Spalte 2 (-k2) sortiert werden muss. Wichtigster Schalter bei tree ist -s für die Anzeige der Dateigröße, die anschließend weiterverarbeitet wird.

Ubuntu Server Part erhöhen

Anyway, parts of the LVM structures (pv and vg) are already reflecting the new size. What is missing is the size of the logical volume and the size of the filesystem. As you can see from pvdisplayand vgdisplay, there are 503 extents = 1.96 GiB still free.

So, first increase the size of the logical volume to that of the volume group:

sudo lvextend -l 100%VG ubuntu-vg/ubuntu-lv

fdisk -l /dev/mapper/ubuntu--vg-ubuntu--lv should then give you the new size of ~ 8.5 GB.

Now, increase the size of the filesystem to that of the logical volume (I suppose ext4 here for '/'; if it is a different filesystem, you will have to use a different command!):

sudo resize2fs /dev/mapper/ubuntu--vg-ubuntu--lv

This is possible for a mounted filesystem, when the kernel supports it, which all recent kernels should do.

Festplatten unter Linux prüfen

Den Status Deiner Festplatte mit smartmontools prüfen.

Neue SSD Festplatten haben eine begrenzte Haltbarkeit. Um diese zu erhöhen bietet sich fstrim an. fstrim gibt Speicher frei und sorgt dafür, dass nicht immer wieder die selben Bereiche Deiner Festplatte beschrieben werden. Daneben ist es ratsam, die Gesundheit Deiner Festplatte im Auge zu behalten. Die kannst Du am besten mit smartmontools prüfen.

Die Installation ist denkbar einfach. Bei den meisten Distributionen kann sie mit dem Paketmanager durchgeführt werden.

Installation unter Arch Linux und Ablegern, wie Manjaro:

sudo pacman -Syu

sudo pacman -S smartmontoolsInstallation unter Debian und Ablegern, wie Ubuntu:

sudo apt install smartmontoolsEinmal installiert, kannst Du Dir Infos zu Deiner Festplatte anzeigen lassen:

sudo smartctl -i /dev/nvme0n1nvme0 musst Du mit Deiner Festplatte ersetzen. Falls Du nicht weisst, wo Deine Festplatte zu finden ist, kannst Du den Befehl inxi nutzen, um sie Dir anzeigen zu lassen.

inxi -dUm smartmontools im nächsten Schritt verwenden zu können, sollte Deine Festplatte S.M.A.R.T. – Self-Monitoring, Analysis und Reporting Technology – unterstützen. Bei den meisten neuen Festplatten ist das der Fall. Falls Du nicht weisst, ob Deine Festplatte SMART unterstützt, kannst Du das durch den Aufruf:

sudo smartctl -i /dev/nvme0n1 Der Aufruf gibt Dir Informationen zu Deiner Festplatte aus. nvme0n1 musst Du, wie gehabt, durch Deine Festplatte ersetzen.

Steht am Ende der Ausgabe so etwas wie: SMART support is: Available, ist alles bestens. Andernfalls kannst Du SMART für die meisten modernen Festplatten einschalten. Das machst Du mit dem Aufruf:

sudo smartctl -s on /dev/nvme0n1Und wieder ersetzt Du nvme0n1 durch Deine Festplatte.

Jetzt ist es soweit, dass Du loslegen kannst. Es gibt drei Arten Deine Festplatte zu testen. Short, long und conveyance. Sie unterscheiden sich vor allem durch die Zeit, die benötigt wird. Empfehlenswert ist in den meisten Fällen long

sudo smartctl -c /dev/nvme0n1

Für einen ausführlichen Test führt folgender Aufruf:

sudo smartctl -t long /dev/nvme0n1Alle Optionen erfährst Du in den Manpages:

man 8 smartctl

man 8 smartd

man 8 update-smart-drivedb

man smartd.confOder gehst auf die Seite: https://www.smartmontools.org/wiki.

Zum Abschluss noch ein paar Sätze zu fstrim. Mit dem Tool kannst Du erst einmal schauen, was passiert, bevor Du es ausführst. Der Aufruf:

sudo fstrim --fstab --verbose --dry-runführt einen Trockenlauf durch. Wenn alles in Ordnung ist, erfolgt der Aufruf nochmals ohne der Option –dry-run. Möchtest Du, dass fstrim bei jedem Neustart Deines Rechners automatisch ausgeführt wird, kannst Du Service mit systemctl einrichten.

sudo systemctl enable fstrim.timer

Linux Festplatte untersuchen

Installieren

sudo apt install ncduVerwendung

ncdu /home/

Docker

Docker Befehle

Docker Befehle

| Befehl | Beschreibung |

|---|---|

| docker start $container | startet den jeweiligen Container |

| docker container ls | running containers |

| docker container ls -a | all containers |

Docker Einführung

Docker installieren:

curl -fsSL https://get.docker.com -o get-docker.sh

sudo sh ./get-docker.sh

Falls kein curl installiert: apt install curl

Wenn man nicht mit dem Nutzer Root arbeitet, sollte man den aktuellen Benutzer berechtigen:

sudo usermod -aG docker $USER

Mit Docker arbeiten

- Laufende Container auflisten:

docker ps - Alle Container auflisten (auch gestoppte):

docker ps -a - Einen Container anhalten:

docker stop <Containername>(den Namen findet man mitdocker ps heraus) - Einen gestoppten Container endgültig löschen:

docker rm <Containername>

Einen simplen Webserver starten

Der Container aus dem Image nginx fährt mit folgendem Befehl hoch:

docker run -p 80:80 nginx

Die eigene IP-Adresse erhält man mit ip a

Arbeiten mit Docker-Compose

Legt euch am besten einen eigenen Ordner für das Docker-Projekt an, um Ordnung zu halten. Die Datei docker-compose.yml enthält die Definition der Container.

Bearbeitet wird die Datei mit:

nano docker-compose.yml

Die Inhalte findet ihr unten in diesem GitHub-Gist. Den Texteditor Nano beendet man mit: Strg+X, dann Y

Die Compose-Zusammenstellung hochfahren:

docker-compose up -d

Will man die Container updaten, lädt man die neuen Images mit

docker-compose pull

Eine oder mehrere Docker-Compose-Dateien?

Das ist definitiv Geschmachssache und hängt von der Umgebung ab. Wenn man mehr als ein Projekt (zum Beispiel einen Blog und ein Pihole) auf einem Server betreibt, sollte man für jedes einen Ordner anlegen und darin eine Docker-Compose-Datei ablegen. Die nützlichen Helfer wie Portainer und Watchtower kommen zusammen in eine weitere Datei. Dann kann man mit docker compose downgezielt Teile der Umgebung herunterfahren.

# Die Docker-Compose-Zusammenstellung für Pihole (https://hub.docker.com/r/pihole/pihole)

services:

pihole:

container_name: pihole

image: pihole/pihole:latest

ports:

- "53:53/tcp"

- "53:53/udp"

- "67:67/udp"

- "80:80/tcp"

environment:

TZ: 'Europe/Berlin'

# WEBPASSWORD: 'set a secure password here or it will be random'

volumes:

- './etc-pihole:/etc/pihole'

- './etc-dnsmasq.d:/etc/dnsmasq.d'

cap_add:

- NET_ADMIN

restart: unless-stopped# Docker-Compose-Datei für Portainer (https://hub.docker.com/r/portainer/portainer-ce). Antwortet auf Port 9000 des Servers

services:

portainer:

image: portainer/portainer-ce

ports:

- 9000:9000

volumes:

- /var/run/docker.sock:/var/run/docker.sock

- ./portainer_data:/data

restart: always

# Docker-Compose-Datei für Watchtower (https://hub.docker.com/r/containrrr/watchtower)

services:

watchtower:

image: containrrr/watchtower

volumes:

- /var/run/docker.sock:/var/run/docker.sock

Docker, Docker-Compose und Portainer installieren

Weitere Infos zu Docker: Docker Einführung

sudo apt update && sudo apt upgrade -yDocker Installation auf Ubuntu

Führe folgende Befehle als root bzw. mit sudo aus:

-

Alle alten Docker-Pakete entfernen (optional, falls vorher installiert):

-

sudo apt-get remove docker docker-engine docker.io containerd runc

-

-

Installationsskript herunterladen und ausführbar machen:

curl -fsSL https://get.docker.com -o get-docker.sh chmod +x get-docker.sh -

Docker installieren:

sudo sh ./get-docker.sh -

Docker-Status prüfen:

sudo systemctl status docker

Du kannst die Gruppenrechte für deinen User noch anpassen, um Docker ohne sudo verwenden zu können:

sudo usermod -aG docker $USER

Danach ab- und neu anmelden.

Docker Compose Installation

Empfohlen wird das aktuelle Compose-Plugin via apt oder als Binary:

Variante 1: Über das Docker Compose Plugin (apt-basiert):

-

Repository aktualisieren:

sudo apt-get update sudo apt-get install docker-compose-plugin -

Installation prüfen:

docker compose version

4. Portainer installieren

docker volume create portainer_datadocker run -d -p 8000:8000 -p 9000:9000 --name=portainer --restart=always -v /var/run/docker.sock:/var/run/docker.sock -v portainer_data:/data portainer/portainer-ce:latestFertig!

Watchtower

Watchtower aktuallisiert auch regelmäßig die Docker Container

Einmal ausführen

docker run --rm \

--name watchtower \

-v /var/run/docker.sock:/var/run/docker.sock \

-e WATCHTOWER_NOTIFICATIONS=email \

-e WATCHTOWER_NOTIFICATION_EMAIL_FROM=hermann.pelzer@mail.de \

-e WATCHTOWER_NOTIFICATION_EMAIL_TO=hp1984@posteo.de \

-e WATCHTOWER_NOTIFICATION_EMAIL_SERVER=smtp.mail.de \

-e WATCHTOWER_NOTIFICATION_EMAIL_SERVER_PORT=587 \

-e WATCHTOWER_NOTIFICATION_EMAIL_SERVER_USER=hermann.pelzer \

-e WATCHTOWER_NOTIFICATION_EMAIL_SERVER_PASSWORD=************ \

-e WATCHTOWER_NOTIFICATION_EMAIL_DELAY=2 \

containrrr/watchtower \

--run-once \

--cleanup \

--include-restarting \

--rolling-restart \

--include-stoppedRegelmäßig ausführen

docker run -it -d \

--name watchtower \

-v /var/run/docker.sock:/var/run/docker.sock \

-e WATCHTOWER_NOTIFICATIONS=email \

-e WATCHTOWER_NOTIFICATION_EMAIL_FROM=hermann.pelzer@mail.de \

-e WATCHTOWER_NOTIFICATION_EMAIL_TO=hp1984@posteo.de \

-e WATCHTOWER_NOTIFICATION_EMAIL_SERVER=smtp.mail.de \

-e WATCHTOWER_NOTIFICATION_EMAIL_SERVER_PORT=587 \

-e WATCHTOWER_NOTIFICATION_EMAIL_SERVER_USER=hermann.pelzer \

-e WATCHTOWER_NOTIFICATION_EMAIL_SERVER_PASSWORD=************* \

-e WATCHTOWER_NOTIFICATION_EMAIL_DELAY=2 \

containrrr/watchtower:latest \

--cleanup \

--include-restarting \

--rolling-restart \

--include-stopped \

--interval 43200Fedora

Bazzite

Update über das Terminal

-

Öffne das Terminal: Du kannst das Terminal entweder über das Menü oder durch Drücken von

Ctrl + Alt + Töffnen. -

Führe den Update-Befehl aus: Gib den folgenden Befehl ein und drücke

Enter:

sudo ujust update-

Dies aktualisiert die Liste der verfügbaren Pakete.

-

Führe das Upgrade durch: Nach dem Update-Befehl, um die installierten Pakete zu aktualisieren, benutze:

sudo ujust upgrade-

Bestätige den Vorgang, wenn du dazu aufgefordert wirst.

-

Neustart: Nach dem Abschluss des Updates ist es meist eine gute Idee, das System neu zu starten, um sicherzustellen, dass alle Änderungen wirksam werden.

cat /etc/os-releaseAnzeige der Installierten Version von bazzite

Typische Befehle für Bazzite Linux (Fedora Silverblue‑basiert)

rpm-ostree install <paket>– Pakete systemweit hinzufügen (Transaktion via rpm‑ostree).rpm-ostree uninstall <paket>– Installierte Pakete wieder entfernen.rpm-ostree upgrade– Das gesamte System auf die neueste OS‑Version aktualisieren.rpm-ostree rollback– Zum vorherigen System‑Snapshot zurückkehren.rpm-ostree status– Aktuellen und vorherigen Deployments anzeigen.rpm-ostree rebase <ref>– Auf einen anderen OS‑Stream (z. B.fedora/38/x86_64/silverblue) umschalten.flatpak install <remote> <app>– Anwendungen per Flatpak hinzufügen.flatpak uninstall <app>– Flatpak‑Anwendungen entfernen.flatpak update– Alle installierten Flatpaks aktualisieren.toolbox create– Eine mutable Toolbox‑Umgebung (Podman‑Container) anlegen.toolbox enter– In die erstellte Toolbox‑Shell wechseln.podman run …– Container direkt mit Podman starten (z. B. für Entwicklungsumgebungen).dnf install <paket>– Nur innerhalb einer Toolbox/Container nutzbar, um klassische RPM‑Pakete zu installieren.systemctl reboot/systemctl poweroff– System neu starten bzw. herunterfahren.

Paketmanager in Fedora DNF

Using the DNF software package manager

DNF is a software package manager that installs, updates, and removes packages on Fedora and is the successor to YUM (Yellow-Dog Updater Modified). DNF makes it easy to maintain packages by automatically checking for dependencies and determines the actions required to install packages. This method eliminates the need to manually install or update the package, and its dependencies, using the rpm command. DNF is now the default software package management tool in Fedora.

Usage

dnf can be used exactly as yum to search, install or remove packages.

To search the repositories for a package type:

# dnf search packagename

To install the package:

# dnf install packagename

To remove a package:

# dnf remove packagename

Other common DNF commands include:

-

autoremove- removes packages installed as dependencies that are no longer required by currently installed programs. -

check-update- checks for updates, but does not download or install the packages. -

downgrade- reverts to the previous version of a package. -

info- provides basic information about the package including name, version, release, and description. -

reinstall- reinstalls the currently installed package. -

upgrade- checks the repositories for newer packages and updates them. -

exclude- exclude a package from the transaction.

For more DNF commands refer to the man pages by typing man dnf at the command-line, or DNF Read The Docs

Automatic Updates

The dnf-automatic package is a component that allows automatic download and installation of updates. It can automatically monitor and report, via e-mail, the availability of updates or send a log about downloaded packages and installed updates.

For more information, refer to the Read the Docs: DNF-Automatic page.

System Upgrades

To update your Fedora Linux release from the command-line do:

sudo dnf upgrade --refresh-

and reboot your computer.

Important: Do not skip this step. System updates are required to receive signing keys of higher-versioned releases, and they often fix problems related to the upgrade process.

-

Download the updated packages:

sudo dnf system-upgrade download --releasever=43

Change the --releasever= number if you want to upgrade to a different release. Most people will want to upgrade to the latest stable release, which is 43, but in some cases, such as when you’re currently running an older release than 42, you may want to upgrade just to Fedora Linux 42. System upgrade is only officially supported and tested over 2 releases at most (e.g. from 41 to 43). If you need to upgrade over more releases, it is recommended to do it in several smaller steps (read more).

Language Support Using DNF

DNF can be used to install or remove Language Support. A detailed description with a list of available languages can be found on Language Support Using Dnf page.

Plugins

The core DNF functionality can be extended with plugins. There are officially supported Core DNF plugins and also third-party Extras DNF Plugins. To install them, run

# dnf install dnf-plugins-core-PLUGIN_NAME

or

# dnf install dnf-plugins-extras-PLUGIN_NAME

Excluding Packages From Transactions

Sometimes it is useful to ignore specific packages from transactions, such as updates. One such case, for example, could be when an update includes a regression or a bug. DNF allows you to exclude a package from the transaction:

-

using the command line

sudo dnf upgrade --exclude=packagename

-

using its configuration files

You can add a line to /etc/dnf/dnf.conf to exclude packages:

excludepkgs=packagename

This can also be added to the specific repository configuration files in /etc/yum.repos.d/. Globs may be used here to list multiple packages, and each specification must be separated by a comma. If you have used this configuration, you can disable it in individual DNF commands using using the --disableexcludes command line switch.

If you use a GUI update application which does not allow you to specify packages to exclude when they run, this method can be used.

Using the DNF Versionlock plugin

You can also use the DNF versionlock plugin to limit the packages that are included in a transaction. It allows you to list what versions of particular packages should be considered in a transaction. All other versions of the specified packages will be ignored. The plugin is part of dnf-plugins-core package and can be installed using the command below:

sudo dnf install 'dnf-command(versionlock)'

To lock the currently installed version of a package, use:

sudo dnf versionlock add package

To remove the version lock, use:

sudo dnf versionlock delete package

The list command can be used to list all locked packages, while the clear command will delete all locked entries.

References

Firewall

Opensense

pfSense

OpnSense installieren

Standard-User

installer

opnsense

root

opnsense

installieren

- Einloggen als installer

- Install ZFS

- stripe

- alles ganz normal

- Qemo auswählen

- Root Passwort ändern

- Complete install

Netzwerk einrichten

Proxmox Shell

vim /etc/network/interfaces

OpnSense Konfigurieren

Auf Proxmox muss QEMU Guast Agent aktiviert sein und auf OpnSense das Plugin installiert.

Videos:

https://www.youtube.com/watch?v=tVX2z85wGmg&t=2556

DNS Server

Entweder DNSforge direkt verwenden oder eben über einen Pi-Hole gehen.

Wichtig: Es sollte Allow DNS server lsit to bie overridden deaktivert werden.

Unbound DNS

Was ist das? Sollte eingeschaltet werden

Konfiguration

Network interfaces > LAN würde reichen

DHCP einstellen

Services > DHCPv4 > Enable DHCP

Range: 10 - 199 dann kann man feste IP-Adressen von 200 ab sauber verteilen

Firewall

NAT Port Forwarding

Dadurch kann man Ports auf diverse PCs weiterleiten

Firewall > NAT > Port Forward

Aliases

Namen zu Hosts zuteilen

- Name Eintragen

- Content: IP-Adresse des Hosts

Man könnte hier alles was über Port 80 rein kommt direkt an einen Reverse Proxy weiter leiten und so den nginx reverse Proxy hinter die Firewall packen

VLANs

Ein VLAN anlegen (Interfaces > Other Types > VLANS)

- Parent: Lan

- VLAN Tag: Zahl zwischen 1 und 4096

Im Anschluss muss das VLAN noch über Assignments an ein Interface verknüpfen

[opt1]

Enable

IPv4 Configuration Type: Static IPv4

IPv4 Adresse: Einstellen (z.B. 10.10.1.1

Danach muss noch DHCP in dem Net aktiviert werden.

Verschlüsseln und Datenschutz

GnuPG

Schnellübersicht

| Befehl |

Kommentar |

gpg -e -r <Empfänger-Schlüssel-ID> <Datei> |

Datei verschlüsseln |

gpg -d <verschlüsselte-Datei.gpg> > entschlüsselte-Datei |

Datei entschlüsseln |

gpg --import private-key.asc |

Schlüssel importieren |

gpg --delete-key |

Gefolgt vom Namen oder Fingerabdruck |

Komplettübersicht

| Befehl | Kommentar |

| gpg -k | Liste der Schlüssel |

Verschlüsseln

Um eine Datei mit GnuPG auf einem Debian Linux zu verschlüsseln, können Sie die folgenden Schritte ausführen:

GnuPG installieren

GnuPG installieren Falls GnuPG noch nicht auf Ihrem Debian Linux-System installiert ist, können Sie es mit folgendem Befehl installieren:

sudo apt-get update sudo apt-get install gnupgSchlüsselpaar generieren

GnuPG-Schlüsselpaar generieren Falls Sie noch keinen GnuPG-Schlüssel haben, müssen Sie zuerst ein Schlüsselpaar generieren. Hierzu können Sie den folgenden Befehl ausführen:

gpg --gen-keyDieser Befehl startet den Assistenten zur Schlüsselerstellung, der Sie durch die Schritte zur Erstellung eines Schlüsselpaars führt. Sie werden unter anderem nach Ihrem Namen, Ihrer E-Mail-Adresse und einem Passwort gefragt. Nachdem der Assistent abgeschlossen ist, wird Ihr Schlüsselpaar generiert und in Ihrem GnuPG-Schlüsselring gespeichert.

Datei verschlüsseln

Um eine Datei zu verschlüsseln, verwenden Sie den folgenden Befehl:

gpg -e -r <Empfänger-Schlüssel-ID> <Datei>Ersetzen Sie <Empfänger-Schlüssel-ID> durch die Schlüssel-ID des Empfängers, an den Sie die verschlüsselte Datei senden möchten. Sie können die Schlüssel-ID des Empfängers entweder in dessen öffentlichem Schlüssel oder in einem Keyserver finden.

Beispiel:

gpg -e -r john@example.com secret.txtDieser Befehl verschlüsselt die Datei secret.txt mit dem öffentlichen Schlüssel, der mit der E-Mail-Adresse john@example.com verknüpft ist.

Schritt 4: Verschlüsselte Datei speichern Nachdem die Datei erfolgreich verschlüsselt wurde, wird eine neue Datei mit der Erweiterung .gpg erstellt, die die verschlüsselten Daten enthält. Sie können diese Datei nun an den Empfänger senden oder anderweitig speichern.

Das war's! Sie haben erfolgreich eine Datei mit GnuPG auf Debian Linux verschlüsselt. Der Empfänger kann die Datei mit seinem privaten Schlüssel entschlüsseln, um auf den Inhalt zuzugreifen

Entschlüsseln am Mac

Verschlüsseln mit GnuPG

Um Ihren privaten Schlüssel von einem Debian Linux-System auf einen Mac zu übertragen und eine mit GnuPG verschlüsselte Datei zu entschlüsseln, können Sie die folgenden Schritte ausführen:

Privaten Schlüssel exportieren

Auf Ihrem Debian Linux-System können Sie Ihren privaten Schlüssel mit dem folgenden Befehl exportieren:

gpg --export-secret-keys -o private-key.ascDieser Befehl exportiert Ihren privaten Schlüssel in eine Datei mit dem Namen private-key.asc. Sie sollten diese Datei sicher speichern, da sie Ihren privaten Schlüssel enthält und Zugriff darauf Dritten ermöglichen würde.

Privaten Schlüssel auf den Mac übertragen

Sie können den privaten Schlüssel private-key.asc auf den Mac übertragen, z.B. per E-Mail, USB-Stick oder über das Netzwerk.

GnuPG auf dem Mac installieren

Falls GnuPG noch nicht auf Ihrem Mac installiert ist, können Sie es mit folgendem Befehl installieren:

brew install gnupgHinweis: Sie müssen Homebrew auf Ihrem Mac installiert haben, um den obigen Befehl auszuführen. Informationen zur Installation von Homebrew finden Sie unter https://brew.sh/.

Privaten Schlüssel auf dem Mac importieren

Nachdem Sie den privaten Schlüssel private-key.asc auf den Mac übertragen haben, können Sie ihn mit dem folgenden Befehl importieren:

gpg --import private-key.ascGnuPG importiert den privaten Schlüssel in Ihren Schlüsselring auf dem Mac.

Datei entschlüsseln

Nachdem Sie Ihren privaten Schlüssel erfolgreich auf dem Mac importiert haben, können Sie die mit GnuPG verschlüsselte Datei entschlüsseln. Verwenden Sie dazu den folgenden Befehl:

gpg -d <verschlüsselte-Datei.gpg> > entschlüsselte-DateiErsetzen Sie <verschlüsselte-Datei.gpg> durch den Dateinamen der verschlüsselten Datei und <entschlüsselte-Datei> durch den gewünschten Dateinamen für die entschlüsselte Datei.

Beispiel:

gpg -d secret.txt.gpg > secret-decrypted.txtDieser Befehl entschlüsselt die Datei secret.txt.gpg und speichert den entschlüsselten Inhalt in der Datei secret-decrypted.txt.

Das war's! Sie haben erfolgreich Ihren privaten Schlüssel von Debian Linux auf einen Mac übertragen und eine mit GnuPG verschlüsselte Datei entschlüsselt. Beachten Sie bitte, dass der private Schlüssel sensitiv ist und mit Vorsicht behandelt werden sollte, um unbefugten Zugriff zu vermeiden

Öffentlichen Schlüssel exportieren

Um einen öffentlichen Schlüssel zu exportieren, müssen Sie den öffentlichen Schlüssel in einer geeigneten Datei speichern. Hier ist ein Beispiel, wie Sie dies mit dem GnuPG (GNU Privacy Guard) Tool tun können, das oft für die Verwaltung von Schlüsselpaaren verwendet wird:

Öffnen Sie ein Terminal auf Ihrem Linux Debian-System.

Überprüfen Sie zunächst, ob GnuPG installiert ist. Wenn es nicht installiert ist, können Sie es mit dem folgenden Befehl installieren:

sudo apt-get update

sudo apt-get install gnupg

Exportieren Sie den öffentlichen Schlüssel mit dem gpg Befehl und speichern Sie ihn in einer Datei. Hier ist ein Beispielbefehl:

gpg --output <Dateiname>.asc --armor --export <Key-ID>

Ersetzen Sie <Dateiname> durch den gewünschten Dateinamen, unter dem der öffentliche Schlüssel gespeichert werden soll, und <Key-ID> durch die ID des öffentlichen Schlüssels, den Sie exportieren möchten. Sie können die ID Ihres öffentlichen Schlüssels mit dem Befehl gpg --list-keys anzeigen lassen.

Beachten Sie, dass der --armor-Schalter verwendet wird, um den exportierten Schlüssel im ASCII-Rüstungformat zu speichern, das häufig für die Weitergabe von Schlüsseln über Text basierte Kanäle wie E-Mail verwendet wird.

Nachdem der Befehl ausgeführt wurde, wird der öffentliche Schlüssel in der angegebenen Datei mit der Erweiterung .asc gespeichert. Sie können die Datei mit einem Texteditor öffnen, um den exportierten öffentlichen Schlüssel anzuzeigen oder ihn auf andere Weise weiterzugeben, z. B. per E-Mail oder auf einer Webseite.

Bitte beachten Sie, dass der öffentliche Schlüssel allgemein zugänglich ist und von jedermann verwendet werden kann, um Ihnen verschlüsselte Nachrichten zu senden oder Ihre Signaturen zu überprüfen. Schützen Sie daher den exportierten öffentlichen Schlüssel sorgfältig und übertragen Sie ihn sicher an die beabsichtigten Empfänger

Öffentlichen Schlüssel importieren

Um einen öffentlichen Schlüssel zu importieren und damit Dateien zu verschlüsseln, können Sie das GnuPG (GNU Privacy Guard) Tool verwenden. Hier ist ein Beispiel, wie Sie dies auf einem Linux Debian-System tun können:

Öffnen Sie ein Terminal auf Ihrem Linux Debian-System.

Überprüfen Sie zunächst, ob GnuPG installiert ist. Wenn es nicht installiert ist, können Sie es mit dem folgenden Befehl installieren:

sudo apt-get update

sudo apt-get install gnupg

Laden Sie den öffentlichen Schlüssel herunter oder erhalten Sie ihn von der Person, die Ihnen die Dateien verschlüsselt hat. Der öffentliche Schlüssel wird normalerweise in einer Datei mit der Erweiterung .asc oder .gpg bereitgestellt.

Importieren Sie den öffentlichen Schlüssel mit dem gpg Befehl. Hier ist ein Beispielbefehl:

gpg --import <Dateiname>.asc

Ersetzen Sie <Dateiname> durch den tatsächlichen Namen der Datei, die den öffentlichen Schlüssel enthält.

GnuPG wird den öffentlichen Schlüssel importieren und in Ihrem GnuPG-Schlüsselbund speichern.

Sie können nun Dateien mit dem importierten öffentlichen Schlüssel verschlüsseln. Verwenden Sie dazu den gpg Befehl und geben Sie den Dateinamen als Argument an. Hier ist ein Beispielbefehl:

gpg --encrypt --recipient <Empfänger> <Dateiname>

Ersetzen Sie <Empfänger> durch den Namen oder die E-Mail-Adresse des Empfängers, für den Sie die Dateien verschlüsseln möchten, und <Dateiname> durch den Namen der Datei, die Sie verschlüsseln möchten.

GnuPG erstellt eine verschlüsselte Version der Datei mit der Erweiterung .gpg. Diese verschlüsselte Datei kann an den Empfänger gesendet werden. Der Empfänger kann die Datei dann mit seinem privaten Schlüssel entschlüsseln.

Bitte beachten Sie, dass der private Schlüssel, der zum Entschlüsseln der Dateien benötigt wird, geheim und sicher aufbewahrt werden muss und nicht an unbefugte Personen weitergegeben werden darf

Keyserver

Unter keyserver2.gnupg.org kann man seinen Key Hochladen und auch andere finden.

Schlüssel vertrauen

-

Schlüssel überprüfen: Überprüfen Sie Ihren eigenen Schlüssel, um sicherzustellen, dass er korrekt erstellt wurde. Sie können dies tun, indem Sie den Fingerabdruck Ihres Schlüssels überprüfen und ihn mit anderen vertrauenswürdigen Quellen, z.B. Ihrer eigenen Notiz oder einem vertrauenswürdigen Freund, abgleichen.

-

Vertrauenseinstellungen ändern: Ändern Sie die Vertrauenseinstellungen für Ihren eigenen Schlüssel. Verwenden Sie dazu den Befehl

gpg --edit-keygefolgt von Ihrem Schlüsselnamen oder Fingerabdruck. Dies öffnet den GnuPG-Editor für Ihren Schlüssel. -

Vertrauensstellung festlegen: Im GnuPG-Editor können Sie die Vertrauensstellung für Ihren eigenen Schlüssel festlegen. Verwenden Sie den Befehl

trust, gefolgt von der gewünschten Vertrauensstufe, die Sie für Ihren eigenen Schlüssel festlegen möchten. Zum Beispiel können Sie die Vertrauensstufe "Ultimate" (höchstes Vertrauen) festlegen, indem Sie5eingeben und mit Enter bestätigen. -

Änderungen speichern: Speichern Sie die vorgenommenen Änderungen im GnuPG-Editor mit dem Befehl

saveund bestätigen Sie die Speicherung mit Enter. -

Editor verlassen: Verlassen Sie den GnuPG-Editor mit dem Befehl

quit, um zum Hauptterminal zurückzukehren.

Schlüssel löschen

-

Geben Sie den Befehl

gpg --list-keysein, um eine Liste der vorhandenen Schlüssel in Ihrem GnuPG-Schlüsselbund anzuzeigen. Finden Sie den Schlüssel, den Sie entfernen möchten, anhand seines Namens oder seines Fingerabdrucks. -

Geben Sie den Befehl

gpg --delete-keygefolgt von dem Namen oder Fingerabdruck des Schlüssels ein, den Sie entfernen möchten. Zum Beispiel:gpg --delete-key JohnDoeodergpg --delete-key 0x12345678.

GPG-Signaturen überprüfen

Eigentlich sollte man niemals Dateien aus dem Internet herunterladen und einfach auf dem eigenen Computer installieren. Linux-Nutzer*innen sollten immer die Paketverwaltung ihres Betriebssystems benutzen, die sicherstellt dass die installierten Pakete vertrauenswürdig sind.

Manchmal ist das aber nicht möglich, zum Beispiel wenn man Windows verwendet. Besonders für sicherheitskritische Software, wie den Tor Browser oder die Passwortverwaltung KeePassXC ist es üblich, die Installations-Datei mit einer digitalen Signatur zu versehen. Dadurch können andere überprüfen, ob die Datei die sie heruntergeladen haben auch tatsächlich der*dem Entwickler*in der Software stammt und keien Schadsoftware beinhaltet.

1. Schritt: Datei und Signatur besorgen

Lade zunächst Datei und Signatur herunter und speichere sie im selben Verzeichnis ab. Eine Signatur-Datei hat immer denselben Namen wie die ursprüngliche Datei mit dem Zusatz „.sig“ oder „.gpg“. Die Signatur-Datei zu einer Datei namens Tor_Browser.exe heißt dann etwa Tor_Browser.exe.sig

2. Schritt: Signatur überprüfen

2.1 Überprüfung mit grafischer Oberfläche

Es gibt für GnuPG verschiedene grafische Frontends, die es dir ersparen Befehle ins Terminal einzugeben.

Windows

Bei der Installation von GPG4Win wirst du gefragt, ob du Kleopatra oder GnuPrivacyAssistend als grafische Oberfläche mitinstallieren möchtest. Kleopatra ist wesentlich benutzer*innenfreundlicher und erweitert das Kontext-Menü (Rechtsklick-Menü) deines Dateibrowsers um die wichtigsten GPG-Funktionen.

Du kannst nun einfach das Verzeichnis öffnen, die Signatur-Datei mit Rechtsklick auswählen und „Entschlüsseln/Überprüfen“ auswählen.

Weiter unter Schritt 3.

Linux

Linux kannst du Kleopatra oder Seahorse verwenden.

Kleopatra

-

integriert sich sehr gut in Kubuntu und andere KDE Desktops.

-

installiere dafür das Paket

kleopatra

Seahorse

-

integriert sich sehr gut in die Desktop-Umgebungen GNOME (dem Standard-Desktop von Ubuntu), MATE und Cinnamon.

-

Installiere dafür Paket

Seahorseund die zugehörige Erweiterung für deinen Filebrowser,seahorse-nautilus(GNOME),nemo-seahorse(Cinnamon)caja-seahorse(MATE)

Nachdem du das passende Programm installiert hast, kannst du das Verzeichnis öffnen in dem die Dateien liegen und mit Rechtsklick auf die Signatur-Datei die Signatur überprüfen.

Weiter unter Schritt 3.

MacOs

Bei der Installation der GPG-Suite wird eine grafisches Oberfläche mitinstalliert. Du kannst im Filebrowser die Signatur-Datei im Kontext-Menü (Rechtsklick) auswählen und die Signatur überprüfen.

Weiter unter Schritt 3.

2.2 Überprüfung mit Terminal

Öffne das Terminal und bewege dich mit cd in das Verzeichnis, in dem die Datei lieg die du überprüfen willst.

cd /Pfad/zur/Datei/

Mit ls kannst du überprüfen, welche Dateien im Verzeichnis liegen (und wie genau sie heißen)

ls

Der Output des Terminals könnte nun sein: Dateiname.exe Dateiname.exe.sig

Jetzt kannst du die Dateien mit GnuPG (gpg) überprüfen. Der kurze Befehl dafür ist gpg –verify. Weil gpg aber den öffentlichen Schlüssel der Unterzeichnerin benötigt, würde es eine Fehlermeldung herausgeben dass es den öffentlichen Schlüssel nicht auf deinem Computer gefunden hat. Als zusätzliche Option kannst du deswegen –auto-key-retrieve angeben. Dadurch wird gpg die Identität der Unterzeichnerin aus der Signatur ablesen, deren Öffentlichen Schlüssel herunterladen und die Dateien überprüfen. Wichtig ist nur, dass im Anschluss daran erst die Signatur, und danach die Datei selber angegeben werden:

gpg --verify --auto-key-retrieve Dateiname.exe.sig Dateiname.exe

3. Schritt: Fingerprint überprüfen

Die Antwort von GPG sollte etwa so aussehen:

gpg: Good signature from "Irgendeine Identität <user@mail.org>" gpg: WARNING: This key is not certified with a trusted signature! gpg: There is no indication that the signature belongs to the owner. Primary key fingerprint: AAAA BBBB CCCC DDDD EEEE FFFF GGGG HHHH IIII

Wichtig ist der Teil Good signature from…

Die Warnung kannst du ignorieren, das bedeuet nur das der Öffentliche Key bisher nicht von dir als vertrauenswürdig signiert wurde.

Aber ob diese Person auch wirklich die richtige ist, musst du selber herausfinden.Dazu schaust du auf der Webseite dieser Person nach, ob der Fingerprint AAAA BBBB CCCC DDDD EEEE FFFF GGGG HHHH IIII auch tatsächlich ihr gehört. Wenn es sich um Software handelt Du kannst den Fingerprint auch in verschiedene Suchmaschinen tippen, und gucken ob es vertrauenswürdige Seiten gibt die diesen Fingerprint mit derjenigen Person assoziieren.

Ordner verschlüsseln

Um einen Ordner in Linux zu verschlüsseln, kannst du das Programm "encfs" verwenden. Hier ist eine Schritt-für-Schritt-Anleitung, wie du vorgehen kannst:

1. Installiere "encfs" auf deinem Linux-System, falls es noch nicht installiert ist. Dies kannst du in der Regel über den Paketmanager deiner Distribution tun. Zum Beispiel kannst du unter Ubuntu den folgenden Befehl ausführen:

sudo apt-get install encfs2. Erstelle einen leeren Ordner, der als "verschlüsselter" Ordner dienen wird. Du kannst dies an einem beliebigen Ort tun. Zum Beispiel:

```

mkdir ~/encrypted_folder

```

3. Führe den folgenden Befehl aus, um den verschlüsselten Ordner einzurichten:

```

encfs ~/encrypted_folder ~/decrypted_folder

```

Dabei ist "~/encrypted_folder" der Pfad zum verschlüsselten Ordner und "~/decrypted_folder" der Pfad zum entschlüsselten Ordner.

4. Während der Einrichtung wirst du nach der Art der Verschlüsselung gefragt. Du kannst die Standardeinstellungen verwenden, indem du einfach Enter drückst.

5. Anschließend wirst du aufgefordert, ein Passwort für die Verschlüsselung festzulegen. Gib ein starkes Passwort ein und bestätige es.

6. Sobald die Einrichtung abgeschlossen ist, kannst du den verschlüsselten Ordner verwenden, indem du Dateien in den entschlüsselten Ordner kopierst. Die Dateien werden automatisch verschlüsselt und im verschlüsselten Ordner gespeichert.

7. Wenn du auf die verschlüsselten Dateien zugreifen möchtest, musst du den verschlüsselten Ordner zunächst mounten. Führe dazu den folgenden Befehl aus:

```

encfs ~/encrypted_folder ~/decrypted_folder

```

8. Du wirst erneut nach dem Passwort gefragt. Gib das Passwort ein, das du bei der Einrichtung festgelegt hast.

9. Sobald der Ordner gemountet ist, kannst du auf die Dateien im entschlüsselten Ordner zugreifen und sie verwenden.

10. Wenn du die verschlüsselten Dateien nicht mehr benötigst, kannst du den Ordner unmounten, indem du den folgenden Befehl ausführst:

```

fusermount -u ~/decrypted_folder

```

Das war's! Du hast jetzt erfolgreich einen Ordner in Linux verschlüsselt.

Tor Systemweit

Um eine systemweite Verbindung zu Tor auf einem Linux-Rechner einzurichten, kannst du den Tor-Dienst installieren und konfigurieren. Hier sind die Schritte dazu:

1. Tor installieren:

- Öffne ein Terminal und füge das Tor-Repository hinzu:

sudo add-apt-repository universe

sudo add-apt-repository ppa:deadsnakes/ppa

sudo apt update

sudo apt install tor2. Tor konfigurieren:

- Bearbeite die Tor-Konfigurationsdatei:

sudo nano /etc/tor/torrc

- Füge folgende Zeilen hinzu, um Tor als Proxy zu verwenden:

SocksPort 9050

- Speichere die Datei und schließe den Editor.

3. Tor-Dienst starten:

- Starte den Tor-Dienst:

sudo systemctl start tor

sudo systemctl enable tor4. Systemweite Proxy-Einstellungen:

- Konfiguriere deine Anwendungen, um den Tor-Proxy zu verwenden. Du kannst dies in den Netzwerkeinstellungen deiner Anwendungen tun, indem du den Proxy auf `localhost` und den Port auf `9050` setzt.

5. Überprüfung:

- Überprüfe, ob der Tor-Dienst läuft:

sudo systemctl status torDiese Schritte sollten dir helfen, eine systemweite Verbindung zu Tor auf deinem Linux-Rechner einzurichten [1](https://de.linux-console.net/?p=4857) [2](https://de.wikihow.com/Unter-Linux-Tor-installieren). Wenn du weitere Fragen hast oder auf Probleme stößt, lass es mich wissen!

Um Tor systemweit auf einem Debian-Rechner zu installieren und es für spezielle Anwendungen zu verwenden, kannst du die folgenden Schritte befolgen:

### 1. Tor installieren

Zuerst musst du das Tor-Paket installieren. Öffne ein Terminal und führe die folgenden Befehle aus:

```bash

sudo apt update

sudo apt install tor

```

### 2. Tor konfigurieren

Die Konfigurationsdatei für Tor befindet sich normalerweise unter `/etc/tor/torrc`. Du kannst diese Datei mit einem Texteditor deiner Wahl bearbeiten:

```bash

sudo nano /etc/tor/torrc

```

Hier kannst du verschiedene Einstellungen vornehmen, z.B. den Port, den Tor verwenden soll, oder spezifische Anwendungsregeln.

### 3. Tor-Dienst starten

Starte den Tor-Dienst mit dem folgenden Befehl:

```bash

sudo systemctl start tor

```

Um sicherzustellen, dass Tor beim Booten automatisch gestartet wird, kannst du den folgenden Befehl verwenden:

```bash

sudo systemctl enable tor

```

### 4. Anwendungen für Tor konfigurieren

Um spezielle Anwendungen über Tor zu leiten, gibt es verschiedene Ansätze, je nach Anwendung:

#### a. Browser (z.B. Firefox)

Um Firefox über Tor zu verwenden, kannst du den Tor-Browser herunterladen und installieren. Alternativ kannst du Firefox so konfigurieren, dass es den Tor-Proxy verwendet:

1. Öffne Firefox und gehe zu den Einstellungen.

2. Wähle „Netzwerkeinstellungen“ und klicke auf „Einstellungen…“.

3. Wähle „Manuelle Proxy-Konfiguration“ und setze den SOCKS-Host auf `127.0.0.1` und den Port auf `9050`.

4. Aktiviere die Option „Proxy für DNS verwenden“ und speichere die Einstellungen.

#### b. Terminal-Anwendungen

Für Terminal-Anwendungen kannst du den Proxy-Umgebungsvariablen setzen. Zum Beispiel:

```bash

export http_proxy="socks5://127.0.0.1:9050"

export https_proxy="socks5://127.0.0.1:9050"

```

Füge diese Zeilen in deine `~/.bashrc` oder `~/.bash_profile` ein, um sie dauerhaft zu machen.

### 5. Überprüfen der Verbindung

Um zu überprüfen, ob deine Verbindung über Tor funktioniert, kannst du die folgende URL in deinem Browser aufrufen:

```

https://check.torproject.org/

```

Diese Seite zeigt dir an, ob du über das Tor-Netzwerk verbunden bist.

### 6. Sicherheitshinweise

- Verwende den Tor-Browser für das Surfen im Internet, um die beste Anonymität zu gewährleisten.

- Sei vorsichtig mit der Verwendung von Plugins oder Erweiterungen, da diese deine Anonymität gefährden können.

Mit diesen Schritten solltest du in der Lage sein, Tor systemweit auf deinem Debian-Rechner zu installieren und es für spezielle Anwendungen zu verwenden.

Verschlüsseln von Dateien und E-Mails

Verschlüsseln mit ccrypt

Das Programm ccrypt kann direkt aus den Paketquellen installiert werden.

-

Verschlüsseln:

ccencrypt foobar

-

Entschlüsseln:

ccdecrypt foobar

-

Entschlüsseln – nur auf die Standardausgabe:

ccat foobar

Weitere Informationen bietet die Manpage zur Anwendung.

GPG

Um ein Dokument zu verschlüsseln, benutzt man die Option --encrypt. Dazu müssen Sie die öffentlichen Schlüssel der vorgesehenen Empfänger haben. Sollten Sie auf der Kommandozeile den Namen der zu verschlüsselnden Datei nicht angeben, werden die zu verschlüsselnden Daten von der Standard-Eingabe gelesen. Das verschlüsselte Resultat wird auf die Standard-Ausgabe oder in die Datei, die durch die Option --output spezifiziert ist, geschrieben. Das Dokument wird darüberhinaus auch noch komprimiert.

alice$ gpg --output doc.gpg --encrypt --recipient blake@cyb.org doc

Mit der Option --recipient wird der öffentliche Schlüssel spezifiziert, mit dem das Dokument verschlüsselt werden soll. Entschlüsseln läßt sich das so verschlüsselte Dokument jedoch nur von jemandem mit dem dazugehörigen geheimen Schlüssel. Das bedeutet konsequenterweise aber auch, daß Sie selbst ein so verschlüsseltes Dokument nur wieder entschlüsseln können, wenn Sie Ihren eigenen öffentlichen Schlüssel in die Empfängerliste aufgenommen haben.

Zum Entschlüsseln einer Nachricht wird die Option --decrypt benutzt. Sie benötigen dazu den geheimen Schlüssel, für den die Nachricht verschlüsselt wurde und das Mantra, mit dem der geheime Schlüssel geschützt ist.

blake$ gpg --output doc --decrypt doc.gpg Sie benötigen ein Mantra, um den geheimen Schlüssel zu entsperren. Benutzer: ``Blake (Staatsanwalt) <blake@cyb.org>'' 1024-Bit ELG-E Schlüssel, ID F251B862, erzeugt 2000-06-06 (Hauptschlüssel-ID B2690E6F)

VPN über Tor

Um einen VPN-Server mit WireGuard einzurichten, der den ausgehenden Traffic über das Tor-Netzwerk leitet, sind mehrere Schritte erforderlich. Hier ist eine allgemeine Anleitung, wie Sie dies umsetzen können:

### Voraussetzungen

- Ein Server (z. B. ein VPS) mit einem Linux-Betriebssystem (z. B. Ubuntu).

- Grundkenntnisse in der Verwendung der Kommandozeile.

- Root-Zugriff auf den Server.

### Schritt 1: WireGuard installieren

1. **Server aktualisieren**:

```bash

sudo apt update

sudo apt upgrade

```

2. **WireGuard installieren**:

```bash

sudo apt install wireguard

```

### Schritt 2: WireGuard konfigurieren

1. **Schlüssel generieren**:

```bash

umask 077

wg genkey | tee privatekey | wg pubkey > publickey

```

2. **WireGuard-Konfigurationsdatei erstellen**:

Erstellen Sie eine Datei `/etc/wireguard/wg0.conf` und fügen Sie Folgendes hinzu:

```ini

[Interface]

PrivateKey = <Ihr privater Schlüssel>

Address = 10.0.0.1/24 # VPN-Subnetz

ListenPort = 51820

[Peer]

PublicKey = <Öffentlicher Schlüssel des Clients>

AllowedIPs = 10.0.0.2/32 # IP des Clients

```

3. **WireGuard aktivieren**:

```bash

sudo wg-quick up wg0

```

### Schritt 3: Tor installieren

1. **Tor installieren**:

```bash

sudo apt install tor

```

2. **Tor konfigurieren**:

Bearbeiten Sie die Tor-Konfigurationsdatei `/etc/tor/torrc` und fügen Sie Folgendes hinzu:

```ini

SocksPort 9050

```

3. **Tor-Dienst starten**:

```bash

sudo systemctl start tor

sudo systemctl enable tor

```

### Schritt 4: Traffic über Tor leiten

1. **IP-Forwarding aktivieren**:

Bearbeiten Sie die Datei `/etc/sysctl.conf` und stellen Sie sicher, dass die folgende Zeile nicht auskommentiert ist:

```ini

net.ipv4.ip_forward=1

```

Wenden Sie die Änderungen an:

```bash

sudo sysctl -p

```

2. **iptables-Regeln hinzufügen**:

Fügen Sie die folgenden iptables-Regeln hinzu, um den Traffic über Tor zu leiten:

```bash

sudo iptables -t nat -A POSTROUTING -o tor0 -j MASQUERADE

sudo iptables -A FORWARD -i wg0 -o tor0 -j ACCEPT

sudo iptables -A FORWARD -i tor0 -o wg0 -m state --state ESTABLISHED,RELATED -j ACCEPT

```

3. **Routing für WireGuard konfigurieren**:

Bearbeiten Sie die WireGuard-Konfigurationsdatei `/etc/wireguard/wg0.conf` und fügen Sie die folgende Zeile hinzu:

```ini

PostUp = iptables -t nat -A POSTROUTING -o tor0 -j MASQUERADE

PostDown = iptables -t nat -D POSTROUTING -o tor0 -j MASQUERADE

```

### Schritt 5: Client konfigurieren

1. **Client-Schlüssel generieren** (auf dem Client):

```bash

umask 077

wg genkey | tee privatekey | wg pubkey > publickey

```

2. **Client-Konfigurationsdatei erstellen**:

Erstellen Sie eine Datei (z. B. `wg0-client.conf`) und fügen Sie Folgendes hinzu:

```ini

[Interface]

PrivateKey = <Ihr privater Schlüssel des Clients>

Address = 10.0.0.2/24 # IP des Clients

[Peer]

PublicKey = <Öffentlicher Schlüssel des Servers>

Endpoint = <Server-IP>:51820

AllowedIPs = 0.0.0.0/0 # Leitet gesamten Traffic über den VPN

```

3. **Client aktivieren**:

```bash

sudo wg-quick up wg0-client

```

### Schritt 6: Testen

- Überprüfen Sie, ob der Client erfolgreich mit dem Server verbunden ist.

- Testen Sie, ob der Traffic über das Tor-Netzwerk geleitet wird, indem Sie eine Website wie `check.torproject.org` besuchen.

###

Ändern des Displaymanagers

In Debian können Sie den Desktop-Umgebungsauswahlmanager ändern, indem Sie verschiedene Desktop-Umgebungen installieren und dann auswählen, welche verwendet werden soll. Hier sind die Schritte, um dies zu tun:

Bitte beachten Sie, dass diese Schritte je nach Debian-Version und verwendeter Desktop-Umgebung variieren können. Es wird empfohlen, die offizielle Dokumentation von Debian sowie die Dokumentation Ihrer spezifischen Desktop-Umgebung zu konsultieren, um die besten Anleitungen für Ihre Konfiguration zu erhalten.

Um zu überprüfen, welche Display Manager auf Ihrem Debian-System installiert sind, können Sie entweder den Inhalt des Verzeichnisses /usr/share/xsessions/ überprüfen oder die Paketliste mit Hilfe des Paketmanagers durchsuchen. Hier sind die Schritte für beide Methoden:

Nachdem Sie einen dieser Schritte ausgeführt haben, sollten Sie eine Liste der installierten Display Manager auf Ihrem Debian-System sehen können.

Um den GNOME-Desktop von einem Debian-System zu deinstallieren, können Sie die entsprechenden GNOME-Pakete über den Paketmanager entfernen. Beachten Sie jedoch, dass das Entfernen des GNOME-Desktops auch andere Pakete entfernen kann, die von anderen Anwendungen oder Desktop-Umgebungen abhängen. Stellen Sie sicher, dass Sie dies berücksichtigen, bevor Sie fortfahren. Hier sind die Schritte, um den GNOME-Desktop zu deinstallieren:

Dieser Befehl entfernt die wichtigsten GNOME-Pakete, einschließlich des GNOME-Shell, der Sitzungsverwaltung, des Systemeinstellungsprogramms, des Terminalprogramms, der Tweaks-Anwendung und der Softwareanwendung.